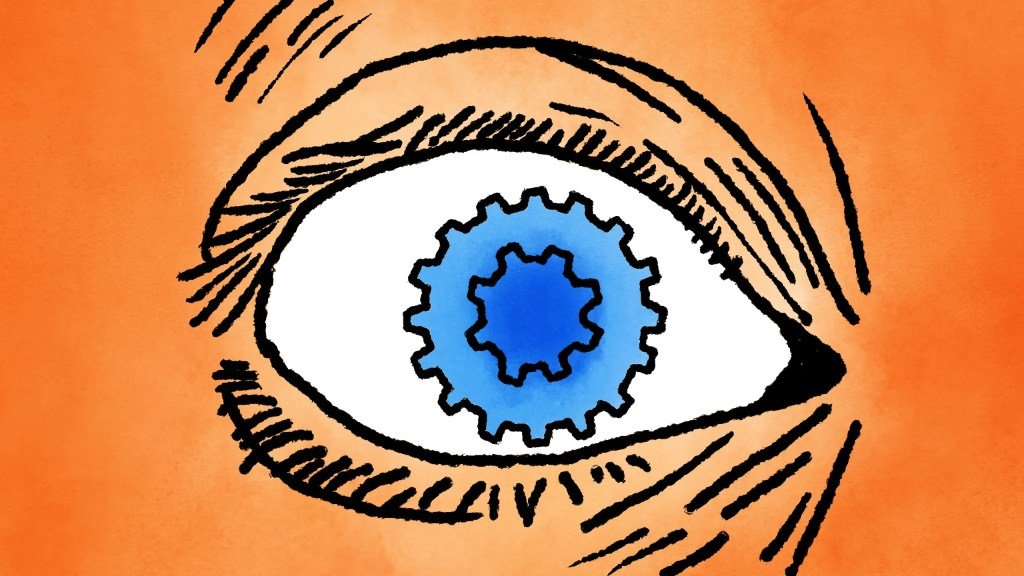

Adakah model AI 'visual' sebenarnya buta?

Majalah bahasa terkini, seperti GPT-4o dan Gemini 1.5 Pro, dipuji sebagai 'multi-modal,' mampu memahami imej dan audio serta teks - tetapi satu kajian baru jelas menunjukkan bahawa mereka sebenarnya tidak melihat seperti yang anda harapkan. Sebenarnya, mereka mungkin tidak melihat sama sekali.

Untuk jelas di awal, tiada sesiapa membuat dakwaan seperti 'AI ini boleh melihat seperti manusia lakukan!' (Eh... mungkin ada beberapa.) Tetapi pemasaran dan penanda aras yang digunakan untuk mempromosikan model tersebut menggunakan frasa seperti 'kemampuan penglihatan,' 'pemahaman visual,' dan sebagainya. Mereka bercakap tentang bagaimana model melihat dan menganalisis imej dan video, jadi ia boleh melakukan apa sahaja dari masalah kerja rumah hingga menonton permainan untuk anda.

Sebuah kajian - tidak formal dari beberapa alat, tetapi sistematik - pemahaman visual model AI semasa dijalankan oleh penyelidik di Auburn University dan University of Alberta. Mereka memberi model multimodal terbesar siri tugas visual yang sangat mudah, seperti meminta sama ada dua bentuk bertindih, atau berapa banyak pentagon dalam gambar, atau huruf mana dalam perkataan yang dikirakan. (Satu micropage ringkasan boleh dibaca di sini.)

'7 tugas kami sangat mudah, di mana manusia akan membuat penampilan pada ketepatan 100%. Kami mengharapkan AI melakukan perkara yang sama, tetapi pada masa ini TIDAK,' tulis penyelidik bersama Anh Nguyen dalam sebuah e-mel kepada TechCrunch. 'Mesej kami adalah 'lihatlah, model-model terbaik ini MASIH gagal.' '

Ambil ujian bentuk bertindih: satu tugas penalaran visual yang paling mudah difikirkan. Diberikan dua bulatan sama ada sedikit bertindih, hanya bersentuhan, atau dengan sedikit jarak di antara mereka, model-model tidak dapat dengan konsisten memperoleh keputusan yang betul. Tentu, GPT-4o memperoleh keputusan yang betul lebih daripada 95% daripada masa apabila mereka jauh, tetapi pada jarak sifar atau kecil, ia hanya memperoleh 18% berjaya! Gemini Pro 1.5 berbuat yang terbaik, tetapi masih hanya mendapat 7/10 pada jarak dekat.

(Ilustrasi tidak menunjukkan prestasi tepat model-model, tetapi dimaksudkan untuk menunjukkan ketidaksempurnaan model-model itu di seluruh keadaan. Statistik bagi setiap model terdapat dalam kertas penyelidikan.)

Bagaimana pula mengira bilangan bulatan yang berkaitan dalam satu imej? Saya fikir kuda di atas purata boleh melakukan ini.

Mereka semua mendapat keputusan yang betul 100% dari masa ketika terdapat 5 cincin - kerja yang bagus AI visual! Tetapi kemudian menambahkan satu cincin sepenuhnya menghancurkan keputusannya. Gemini hilang, tidak mampu memperoleh keputusan yang tepat sekali pun. Sonnet-3.5 menjawab 6... sepertiga masa, dan GPT-4o sedikit di bawah separuh masa. Menambahkan satu cincin lagi menjadikannya lebih sukar, tetapi menambahkan yang lain menjadikannya lebih mudah untuk sesetengah.

Tugas-tugas lain yang diuji menunjukkan corak yang serupa: bukanlah mereka melihat atau menalar dengan baik atau buruk, tetapi kelihatan ada alasan lain mengapa mereka mampu mengira dalam satu kes tetapi tidak dalam kes yang lain.

Logo ini tidak hanya diulang berulang kali dalam data latihan tetapi kemungkinan dijelaskan dengan terperinci dalam teks alternatif, garis panduan penggunaan, dan artikel tentangnya. Tetapi di mana dalam data latihan mereka anda akan menjumpai 6 cincin yang berkaitan, atau 7? Jika respon mereka menjadi petunjuk... tiada! Mereka tidak tahu apa yang mereka 'lihat,' dan tidak ada pemahaman visual sebenar tentang cincin, pertindihan, atau apa-apa lagi.

Saya bertanya kepada penyelidik apa pendapat mereka tentang 'buta' yang mereka tuduhkan pada model-model ini. Seperti terma lain yang kami gunakan, ia memiliki kualiti antropomorfik yang tidak sepenuhnya tepat tetapi sukar dilakukan tanpanya.

‘Saya bersetuju, 'tuli' mempunyai pelbagai definisi bahkan untuk manusia dan belum ada lagi perkataan untuk jenis kebutaan/kepekaan ini AI terhadap imej yang kami tunjukkan,' tulis Nguyen. "Pada masa ini, tiada teknologi untuk memvisualisasikan dengan tepat apa yang dilihat oleh model. Dan tingkah laku mereka adalah fungsi kompleks daripada input teks prompt, input imej, dan berbilion jisim berat."'

Apa yang berlaku apabila satu bulatan biru dan satu bulatan hijau bertindih (seperti soalan menyuruh model membuat fakta), sering kali terdapat kawasan berwarna sian, seperti dalam gambar Venn. Jika sesiapa bertanya soalan ini kepada anda, anda atau mana-mana individu bijak mungkin memberi jawapan yang sama, kerana itu benar-benar masuk akal... jika mata anda tertutup! Tetapi tiada sesiapa dengan mata terbuka akan menyelesaikannya.